text

stringlengths 51

1.2k

| lang

stringclasses 2

values | title

stringclasses 5

values |

|---|---|---|

[](/wiki/Fichier:%E3%82%B9%E3%83%9E%E3%83%BC%E3%83%88%E3%82%B9%E3%83%94%E3%83%BC%E3%82%AB%E3%83%BC.jpg)Dans les années 2010, les [assistants personnels intelligents](/wiki/Assistant_personnel_intelligent "Assistant personnel intelligent") sont l'une des premières applications grand public de l'intelligence artificielle.

L'**intelligence artificielle** (**IA**) est un ensemble de théories et de techniques visant à réaliser des machines capables de [simuler](/wiki/Simulation_informatique "Simulation informatique") l'[intelligence humaine](/wiki/Intelligence_humaine "Intelligence humaine")[[1]](#cite_note-1).

Souvent classée dans le domaine des [mathématiques](/wiki/Math%C3%A9matiques "Mathématiques") et des [sciences cognitives](/wiki/Sciences_cognitives "Sciences cognitives"), l'IA fait appel à des disciplines telles que la [neurobiologie computationnelle](/wiki/R%C3%A9seau_de_neurones_(biologie) "Réseau de neurones (biologie)") (qui a notamment inspir | fr | ai.md |

é les [réseaux neuronaux artificiels](/wiki/R%C3%A9seau_de_neurones_artificiels "Réseau de neurones artificiels")), les [statistiques](/wiki/Statistique "Statistique"), ou l'[algèbre linéaire](/wiki/Alg%C3%A8bre_lin%C3%A9aire "Algèbre linéaire"). Elle vise à résoudre des problèmes à forte complexité [logique](/wiki/Logique "Logique") ou [algorithmique](/wiki/Algorithmique "Algorithmique"). Par extension, dans le [langage](/wiki/Langage "Langage") courant, l'IA inclut les dispositifs imitant ou remplaçant l'homme dans certaines mises en uvre de ses [fonctions cognitives](/wiki/Cognition "Cognition")[[2]](#cite_note-2).

Les [applications de l'IA](/wiki/Applications_de_l%27intelligence_artificielle "Applications de l'intelligence artificielle") incluent notamment les [moteurs de recherche](/wiki/Moteur_de_recherche "Moteur de recherche"), les [systèmes de recommandation](/wiki/Syst%C3%A8me_de_recommandation "Système de recommandation"), la [compréhension du langage naturel](/wiki/Compr%C3%A9hension_du_langage_naturel "Compréhension du langage naturel"), les [voitures autonomes](/wiki/V%C3%A9hicule_autonome "Véhicule autonome"), les [chatbots](/wiki/Chatbot "Chatbot"), les outils de [ | fr | ai.md |

génération d'images](/wiki/Art_cr%C3%A9%C3%A9_par_intelligence_artificielle "Art créé par intelligence artificielle"), les outils de prise de décision automatisée et les programmes compétitifs dans des jeux de stratégie[[3]](#cite_note-3).

Depuis l'apparition du concept, les finalités, les enjeux et le développement de l'IA suscitent de nombreuses interprétations, fantasmes ou inquiétudes, que l'on retrouve dans les récits ou films de [science-fiction](/wiki/Science-fiction "Science-fiction") ainsi que dans les [essais philosophiques](/wiki/Philosophie "Philosophie")[[4]](#cite_note-4). Des outils d'intelligence artificielle (spécialisée ou générative) ont accompli des progrès spectaculaires dans les années 2010-2020, mais restent loin des performances du vivant dans toutes ses aptitudes naturelles, selon le magazine *[Slate](/wiki/Slate_(magazine) "Slate (magazine)")* en 2019[[5]](#cite_note-5).

Le terme « intelligence artificielle », créé par [John McCarthy](/wiki/John_McCarthy "John McCarthy"), est souvent abrégé par le sigle « IA » (ou « AI » en anglais, pour *artificial intelligence*). McCarthy définit l'IA ainsi : « C'est la science et l'ingénierie de la fabrication de mach | fr | ai.md |

ines intelligentes, en particulier de programmes informatiques intelligents. Elle est liée à la tâche similaire qui consiste à utiliser des ordinateurs pour comprendre l'intelligence humaine, mais l'IA ne doit pas se limiter aux méthodes qui sont biologiquement observables[[6]](#cite_note-6). »

Elle est également définie par l'un de ses créateurs, [Marvin Lee Minsky](/wiki/Marvin_Minsky "Marvin Minsky"), comme « la construction de programmes informatiques qui s'adonnent à des tâches qui sont, pour l'instant, accomplies de façon plus satisfaisante par des êtres humains car elles demandent des processus mentaux de haut niveau tels que : l'apprentissage perceptuel, l'organisation de la mémoire et le raisonnement critique »[[a]](#cite_note-7),[[7]](#cite_note-8). On y trouve donc le côté « artificiel » atteint par l'usage des [ordinateurs](/wiki/Ordinateur "Ordinateur") ou de processus électroniques élaborés et le côté « intelligence » associé à son but d'imiter le [comportement](/wiki/Comportement "Comportement"). Cette imitation peut se faire dans le raisonnement, par exemple dans les jeux ou la pratique des [mathématiques](/wiki/Math%C3%A9matiques "Mathématiques"), dans la [compréh | fr | ai.md |

ension des langues naturelles](/wiki/Compr%C3%A9hension_du_langage_naturel "Compréhension du langage naturel"), dans la perception : visuelle (interprétation des images et des scènes), auditive (compréhension du langage parlé) ou par d'autres capteurs, dans la commande d'un [robot](/wiki/Robot "Robot") dans un milieu inconnu ou hostile.

Même si elles respectent globalement la définition de Minsky, certaines définitions de l'IA varient sur deux points fondamentaux[[8]](#cite_note-9) :

* les définitions qui lient l'IA à un aspect *humain* de l'[intelligence](/wiki/Intelligence "Intelligence"), et celles qui la lient à un modèle idéal d'intelligence, non forcément humaine, nommée *[rationalité](/wiki/Rationalit%C3%A9 "Rationalité")* ;

* les définitions qui insistent sur le fait que l'IA a pour but d'avoir *toutes les apparences* de l'intelligence (humaine ou rationnelle), et celles qui insistent sur le fait que le *fonctionnement interne* du système d'IA doit ressembler également à celui de l'être humain et être au moins aussi [rationnel](/wiki/Inf%C3%A9rence_bay%C3%A9sienne "Inférence bayésienne").

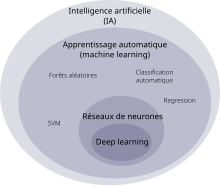

[](/wiki/Fichier:Carto_IA_deepLearning.svg)[Diagramme de Venn](/wiki/Diagramme_de_Venn "Diagramme de Venn") montrant comment s'imbriquent les notions d'intelligence artificielle, d'apprentissage automatique et d'apprentissage profond.

Il y a une confusion fréquente dans le débat public entre intelligence artificielle, [apprentissage automatique](/wiki/Apprentissage_automatique "Apprentissage automatique") (*machine learning*) et [apprentissage profond](/wiki/Apprentissage_profond "Apprentissage profond") (*deep learning*). Pourtant, ces notions ne sont pas équivalentes, mais imbriquées. L'intelligence artificielle englobe l'apprentissage automatique, qui lui-même englobe l'apprentissage profond[[9]](#cite_note-10).

Pour l'[OCDE](/wiki/OCDE "OCDE"), un système d'IA est « un système basé sur une machine qui, pour des objectifs explicites ou implicites, déduit, à partir des informations qu'il reçoit, comment générer des résultats tels que des prédictions, du contenu, des recommandations ou des décisions, qui peuvent influencer les environnements physiques ou | fr | ai.md |

virtuels. Les différents systèmes d'IA varient dans leurs niveaux d'autonomie et d'adaptabilité après leur déploiement »[[10]](#cite_note-11)

L'[apprentissage automatique](/wiki/Apprentissage_automatique "Apprentissage automatique") consiste à permettre au modèle d'IA d'apprendre à effectuer une tâche au lieu de spécifier exactement comment il doit l'accomplir[[11]](#cite_note-:0-12). Le modèle contient des paramètres dont les valeurs sont ajustées tout au long de l'apprentissage. La méthode de la [rétropropagation du gradient](/wiki/R%C3%A9tropropagation_du_gradient "Rétropropagation du gradient") est capable de détecter, pour chaque paramètre, dans quelle mesure il a contribué à une bonne réponse ou à une erreur du modèle, et peut l'ajuster en conséquence. L'apprentissage automatique nécessite un moyen d'évaluer la qualité des réponses fournies par le modèle[[12]](#cite_note-13). Les principales méthodes d'apprentissage sont :

### Réseaux de neurones[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=4 "Modifier la section: Réseaux de neurones") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=4 "Modifier le code | fr | ai.md |

source de la section : Réseaux de neurones")]

[](/wiki/Fichier:Neural_network.svg)Exemple de réseau de neurones comprenant deux neurones d'entrée (en vert), une couche « cachée » de neurones (en bleu) et un neurone de sortie (en jaune).

Les [réseaux de neurones artificiels](/wiki/R%C3%A9seau_de_neurones_artificiels "Réseau de neurones artificiels") sont inspirés du fonctionnement du [cerveau humain](/wiki/Cerveau_humain "Cerveau humain") : les [neurones](/wiki/Neurone "Neurone") sont en général connectés à d'autres neurones en entrée et en sortie. Les neurones d'entrée, lorsqu'ils sont activés, agissent comme s'ils participaient à un [vote pondéré](/wiki/Vote_pond%C3%A9r%C3%A9 "Vote pondéré") pour déterminer si un neurone intermédiaire doit être activé et ainsi transmettre un signal vers les neurones de sortie. En pratique, pour l'équivalent artificiel, les « neurones d'entrée » ne sont que des nombres et les poids de ce « vote pondéré » sont des paramètres ajustés lors de l'apprentissage[[15]](#cite_note-16),[[16]](#cite_note-:12-17).

À part la [fonction d'activation](/wiki/Fo | fr | ai.md |

nction_d%27activation "Fonction d'activation"), les réseaux de neurones artificiels n'effectuent en pratique que des additions et des [multiplications matricielles](/wiki/Produit_matriciel "Produit matriciel"), ce qui fait qu'ils peuvent être accélérés par l'utilisation de [processeurs graphiques](/wiki/Processeur_graphique "Processeur graphique")[[17]](#cite_note-18). En théorie, un réseau de neurones peut apprendre n'importe quelle [fonction](/wiki/Fonction_(math%C3%A9matiques) "Fonction (mathématiques)")[[18]](#cite_note-19).

Pour de simples [réseaux de neurones à propagation avant](/wiki/R%C3%A9seau_de_neurones_%C3%A0_propagation_avant "Réseau de neurones à propagation avant") (*feedforward* en anglais), le signal ne passe que dans une direction. Avec les [réseaux de neurones récurrents](/wiki/R%C3%A9seau_de_neurones_r%C3%A9currents "Réseau de neurones récurrents"), le signal de sortie de chaque neurone est réinjecté en entrée de ce neurone, permettant un mécanisme de mémoire à court terme[[19]](#cite_note-20). Les [réseaux neuronaux convolutifs](/wiki/R%C3%A9seaux_neuronaux_convolutifs "Réseaux neuronaux convolutifs"), qui sont particulièrement utilisés en [traitement d'image | fr | ai.md |

s](/wiki/Traitement_d%27images "Traitement d'images"), introduisent une notion de localité. Leurs premières couches identifient des motifs relativement basiques et locaux comme des contours, là où les dernières couches traitent de motifs plus complexes et globaux[[16]](#cite_note-:12-17).

L'[apprentissage profond](/wiki/Apprentissage_profond "Apprentissage profond") (*deep learning* en anglais) utilise de multiples couches de neurones entre les entrées et les sorties, d'où le terme « profond »[[20]](#cite_note-21). L'utilisation de [processeurs graphiques](/wiki/Processeur_graphique "Processeur graphique") pour accélérer les calculs et l'augmentation des données disponibles a contribué à la montée en popularité de l'apprentissage profond. Il est utilisé notamment en [vision par ordinateur](/wiki/Vision_par_ordinateur "Vision par ordinateur"), en [reconnaissance automatique de la parole](/wiki/Reconnaissance_automatique_de_la_parole "Reconnaissance automatique de la parole") et en [traitement du langage naturel](/wiki/Traitement_automatique_du_langage_naturel "Traitement automatique du langage naturel")[[21]](#cite_note-22) (ce qui inclut les [grands modèles de langage](/wiki/Grand | fr | ai.md |

_mod%C3%A8le_de_langage "Grand modèle de langage")).

### Grands modèles de langages[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=6 "Modifier la section: Grands modèles de langages") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=6 "Modifier le code source de la section : Grands modèles de langages")]

Les [grands modèles de langage](/wiki/Grand_mod%C3%A8le_de_langage "Grand modèle de langage") sont des [modèles de langage](/wiki/Mod%C3%A8le_de_langage "Modèle de langage") ayant un grand nombre de paramètres, typiquement des milliards. Ils reposent très souvent sur l'architecture [transformeur](/wiki/Transformeur "Transformeur")[[22]](#cite_note-:22-23).

Les [transformeurs génératifs pré-entraînés](/wiki/Transformeur_g%C3%A9n%C3%A9ratif_pr%C3%A9-entra%C3%AEn%C3%A9 "Transformeur génératif pré-entraîné") (*Generative Pretrained Transformers* ou *GPT* en anglais) sont un type particulièrement populaire de grand modèle de langage. Leur « pré-entraînement » consiste à prédire, étant donnée une partie d'un texte, le [*token*](/wiki/Analyse_lexicale "Analyse lexicale") suivant (un *token* étant une séquence de caract | fr | ai.md |

ères, typiquement un mot, une partie d'un mot, ou de la ponctuation). Cet entraînement à prédire ce qui va suivre, répété pour un grand nombre de textes, permet à ces modèles d'accumuler des connaissances sur le monde. Ils peuvent ensuite générer du texte semblable à celui ayant servi au pré-entraînement, en prédisant un à un les *tokens* suivants. En général, une autre phase d'entraînement est ensuite effectuée pour rendre le modèle plus véridique, utile et inoffensif. Cette phase d'entraînement (utilisant souvent une technique appelée RLHF) permet notamment de réduire un phénomène appelé « [hallucination](/wiki/Hallucination_(intelligence_artificielle) "Hallucination (intelligence artificielle)") », où le modèle génère des informations d'apparence plausible mais fausses[[23]](#cite_note-24).

Avant d'être fourni au modèle, le texte est découpé en *tokens*. Ceux-ci sont [convertis en vecteurs](/wiki/Plongement_lexical "Plongement lexical") qui en encodent le sens ainsi que la position dans le texte. À l'intérieur de ces modèles se trouve une alternance de réseaux de neurones et de couches d'attention. Les couches d'attention combinent les concepts entre eux, permettant de tenir co | fr | ai.md |

mpte du contexte et de saisir des relations complexes[[24]](#cite_note-:3-25).

Ces modèles sont souvent intégrés dans des [agents conversationnels](/wiki/Agent_conversationnel "Agent conversationnel"), où le texte généré est formaté pour répondre à l'utilisateur. Par exemple, l'agent conversationnel [ChatGPT](/wiki/ChatGPT "ChatGPT") exploite les modèles [GPT-3.5](/wiki/GPT-3 "GPT-3") et [GPT-4](/wiki/GPT-4 "GPT-4")[[25]](#cite_note-26). En 2023 font leur apparition des modèles grand public pouvant traiter simultanément différents types de données comme le texte, le son, les images et les vidéos, tel [Google Gemini](/wiki/Google_Gemini "Google Gemini")[[26]](#cite_note-27).

### Recherche et optimisation[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=7 "Modifier la section: Recherche et optimisation") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=7 "Modifier le code source de la section : Recherche et optimisation")]

Certains problèmes nécessitent de chercher intelligemment parmi de nombreuses solutions possibles.

[](/wiki/Fichier:Gradient_descent.gif)Illustration de la [descente de gradient](/wiki/Descente_de_gradient "Descente de gradient") pour trois points de départ différents, faisant varier deux paramètres de sorte à minimiser la [fonction de coût](/wiki/Fonction_objectif "Fonction objectif") représentée par la hauteur.

La [recherche locale](/wiki/Recherche_locale_(optimisation) "Recherche locale (optimisation)"), ou recherche par optimisation, repose sur l'optimisation mathématique pour trouver une solution numérique à un problème, en améliorant progressivement la solution choisie[[27]](#cite_note-:42-28).

En particulier, en apprentissage automatique, la [descente de gradient](/wiki/Algorithme_du_gradient "Algorithme du gradient") permet de trouver une solution [localement optimale](/wiki/Extremum "Extremum"), étant donné une [fonction de coût](/wiki/Fonction_objectif "Fonction objectif") à minimiser en faisant varier les paramètres du modèle. Elle consiste, à chaque étape, à modifier les paramètres à optimiser dans la direction qui permet de réduire le mieux la fonction de coût. La solution obtenue est *localement* optimale, mais il se peut qu'il y ait globalement de meilleu | fr | ai.md |

res solutions, qui auraient pu être obtenues avec différentes valeurs initiales de paramètres[[27]](#cite_note-:42-28). Les modèles d'IA modernes peuvent avoir des milliards de paramètres à optimiser, et utilisent souvent des variantes plus complexes et efficaces de la descente de gradient[[22]](#cite_note-:22-23).

Les [algorithmes évolutionnistes](/wiki/Algorithme_%C3%A9volutionniste "Algorithme évolutionniste") (inspirés de la [théorie de l'évolution](/wiki/Th%C3%A9orie_synth%C3%A9tique_de_l%27%C3%A9volution "Théorie synthétique de l'évolution")) utilisent une forme de recherche par optimisation. À chaque étape, des opérations telles que la « mutation » ou le « croisement » sont effectuées aléatoirement pour obtenir différentes variantes, et les variantes les mieux adaptées sont sélectionnées pour l'étape suivante[[27]](#cite_note-:42-28).

#### Recherche dans l'espace des états[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=9 "Modifier la section: Recherche dans l'espace des états") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=9 "Modifier le code source de la section : Recherche dans l'espace des états")]

| fr | ai.md |

La recherche dans l'[espace des états](/wiki/Espace_des_phases "Espace des phases") vise à trouver un état accomplissant l'objectif à travers un arbre des états possibles[[28]](#cite_note-29). Par exemple, la recherche antagoniste est utilisée pour des programmes jouant à des jeux tels que les [échecs](/wiki/%C3%89checs "Échecs") ou le [go](/wiki/Go_(jeu) "Go (jeu)"). Elle consiste à parcourir l'[arbre](/wiki/Arbre_de_jeu "Arbre de jeu") des coups possibles par le joueur et son adversaire, à la recherche d'un coup gagnant[[29]](#cite_note-30). La simple [recherche exhaustive](/wiki/Recherche_exhaustive "Recherche exhaustive") est rarement suffisante en pratique vu le nombre d'états possibles. Des [heuristiques](/wiki/Heuristique "Heuristique") sont utilisées pour prioriser les chemins les plus prometteurs[[30]](#cite_note-31).

La [logique formelle](/wiki/Logique_formelle "Logique formelle") est utilisée pour le [raisonnement](/wiki/Raisonnement "Raisonnement") et la [représentation des connaissances](/wiki/Repr%C3%A9sentation_des_connaissances "Représentation des connaissances"). Elle se décline en deux principales formes, la [logique propositionnelle](/wiki/Calcul_des_proposition | fr | ai.md |

s "Calcul des propositions") et la logique prédicative. La logique propositionnelle opère sur des affirmations qui sont vraies ou fausses, et utilise la logique connective avec des [opérateurs](/wiki/Connecteur_logique_(linguistique) "Connecteur logique (linguistique)") tels que « et », « ou », « non » et « implique ». La logique prédicative étend la logique propositionnelle et peut aussi opérer sur des objets, prédicats ou relations. Elle peut utiliser des [quantificateurs](/wiki/Quantification_(logique) "Quantification (logique)") comme dans « *Chaque* X est un Y » ou « *Certains* X sont des Y »[[31]](#cite_note-:52-32).

L'[inférence](/wiki/Inf%C3%A9rence_(logique) "Inférence (logique)") logique (ou [déduction](/wiki/D%C3%A9duction_logique "Déduction logique")) est le processus qui consiste à fournir une nouvelle affirmation (la conclusion) à partir d'autres affirmations connues comme étant vraies (les [prémisses](/wiki/Pr%C3%A9misse "Prémisse")). Une [règle d'inférence](/wiki/R%C3%A8gle_d%27inf%C3%A9rence "Règle d'inférence") décrit les étapes valides d'une [preuve](/wiki/Preuve "Preuve") ; la plus générale est la [règle de résolution](/wiki/R%C3%A8gle_de_r%C3%A9solution "Règle | fr | ai.md |

de résolution"). L'inférence peut être réduite à la recherche d'un chemin amenant des prémisses aux conclusions, où chaque étape est une application d'une règle d'inférence[[31]](#cite_note-:52-32). Mais à part pour de courtes preuves dans des domaines restreints, la recherche exhaustive prend trop de temps.

La [logique floue](/wiki/Logique_floue "Logique floue") assigne des [valeurs de vérité](/wiki/Valeur_de_v%C3%A9rit%C3%A9 "Valeur de vérité") entre 0 et 1, permettant de gérer des affirmations vagues, comme « il fait chaud »[[32]](#cite_note-33). La [logique non monotone](/wiki/Logique_non_monotone "Logique non monotone") permet d'annuler certaines conclusions[[31]](#cite_note-:52-32). Divers autres formes de logique sont développées pour décrire de nombreux domaines complexes.

### Méthodes probabilistes et gestion de l'incertitude[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=11 "Modifier la section: Méthodes probabilistes et gestion de l'incertitude") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=11 "Modifier le code source de la section : Méthodes probabilistes et gestion de l'incertitude")]

[](/wiki/Fichier:SimpleR%C3%A9seauBay%C3%A9sien.svg)Un exemple de [réseau bayésien](/wiki/R%C3%A9seau_bay%C3%A9sien "Réseau bayésien"), et les tables de probabilité conditionnelle associées.

De nombreux problèmes en IA (raisonnement, planification, apprentissage, perception, robotique..) nécessitent de pouvoir opérer à partir d'informations incomplètes ou incertaines[[33]](#cite_note-34).

Certaines techniques reposent sur l'[inférence bayésienne](/wiki/Inf%C3%A9rence_bay%C3%A9sienne "Inférence bayésienne"), qui fournit une formule pour mettre à jour des [probabilités subjectives](/wiki/Probabilit%C3%A9_bay%C3%A9sienne "Probabilité bayésienne") étant données de nouvelles informations. C'est notamment le cas des [réseaux bayésiens](/wiki/R%C3%A9seau_bay%C3%A9sien "Réseau bayésien"). L'inférence bayésienne nécessite souvent d'être approximée pour pouvoir être calculée[[34]](#cite_note-:02-35).

Les [méthodes de Monte-Carlo](/wiki/M%C3%A9thode_de_Monte-Carlo "Méthode de Monte-Carlo") sont un ensemble de techniques pour résoudre des problèmes complexes en effec | fr | ai.md |

tuant aléatoirement de nombreuses simulations afin d'approximer la solution[[35]](#cite_note-36).

Les réseaux de neurones peuvent aussi être optimisés pour fournir des estimations probabilistes[[36]](#cite_note-37).

Des outils mathématiques précis ont été développés pour analyser comment des [agents](/wiki/Agent_intelligent "Agent intelligent") peuvent faire des choix et des plans en utilisant la [théorie de la décision](/wiki/Th%C3%A9orie_de_la_d%C3%A9cision "Théorie de la décision"), la maximisation de l'[espérance](/wiki/Esp%C3%A9rance_math%C3%A9matique "Espérance mathématique") et la théorie de la valeur de l'information. Ces techniques comprennent des modèles tels que les [processus de décision markoviens](/wiki/Processus_de_d%C3%A9cision_markovien "Processus de décision markovien"), la [théorie des jeux](/wiki/Th%C3%A9orie_des_jeux "Théorie des jeux") et les [mécanismes d'incitation](/wiki/Th%C3%A9orie_des_m%C3%A9canismes_d%27incitation "Théorie des mécanismes d'incitation")[[34]](#cite_note-:02-35).

### Classifieurs et méthodes statistiques[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=12 "Modifier la section: Classifieurs et méthodes stati | fr | ai.md |

stiques") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=12 "Modifier le code source de la section : Classifieurs et méthodes statistiques")]

De nombreux modèles d'IA ont pour but d'assigner une catégorie ([classification](/wiki/Classement_automatique "Classement automatique")), une valeur (régression) ou une action à des données fournies. Les méthodes de classification comprennent [arbres de décision](/wiki/Arbre_de_d%C3%A9cision "Arbre de décision"), [k plus proches voisins](/wiki/K_plus_proches_voisins "K plus proches voisins"), [machine à vecteurs de support](/wiki/Machine_%C3%A0_vecteurs_de_support "Machine à vecteurs de support") ou [classification bayésienne naïve](/wiki/Classification_na%C3%AFve_bay%C3%A9sienne "Classification naïve bayésienne")[[37]](#cite_note-38),[[34]](#cite_note-:02-35). Les réseaux de neurones peuvent également faire de la classification[[38]](#cite_note-39).

Comme précurseur à l'intelligence artificielle, divers [automates](/wiki/Automate "Automate") ont été créés au cours de l'histoire, dont le [canard de Vaucanson](/wiki/Canard_de_Vaucanson "Canard de Vaucanson") ou les automates d'[Al-Jazari](/wiki/Al-Jazar | fr | ai.md |

i "Al-Jazari"). Certains automates remontent à l'[Antiquité](/wiki/Antiquit%C3%A9 "Antiquité") et étaient utilisés pour des cérémonies religieuses[[39]](#cite_note-40). Des mythes et rumeurs rapportent également la création d'êtres intelligents, par exemple les [golems](/wiki/Golem "Golem")[[40]](#cite_note-41).

Des philosophes et mathématiciens comme [Raymond Lulle](/wiki/Raymond_Lulle "Raymond Lulle"), [Leibniz](/wiki/Leibniz "Leibniz") ou [George Boole](/wiki/George_Boole "George Boole") ont cherché à formaliser le raisonnement et la génération d'idées[[41]](#cite_note-:33-42).

Au XXe siècle, [Alan Turing](/wiki/Alan_Turing "Alan Turing") a notamment inventé un modèle de calcul par la suite appelé [machine de Turing](/wiki/Machine_de_Turing "Machine de Turing"), exploré la notion de [calculabilité](/wiki/Calculabilit%C3%A9 "Calculabilité") et d'intelligence des machines, et proposé le « jeu de l'imitation » ([test de Turing](/wiki/Test_de_Turing "Test de Turing")) pour évaluer l'intelligence de futures machines[[41]](#cite_note-:33-42). Le terme « intelligence artificielle » a été mis en avant par [John McCarthy](/wiki/John_McCarthy "John McCarthy") lors de la [conférence de D | fr | ai.md |

artmouth](/wiki/Conf%C3%A9rence_de_Dartmouth "Conférence de Dartmouth") en 1956, où l'intelligence artificielle a été établie en tant que discipline à part entière[[42]](#cite_note-43),[[43]](#cite_note-44). Dans les années qui ont suivi, des chercheurs ont proposé diverses [preuves de concept](/wiki/Preuve_de_concept "Preuve de concept"), dans des situations spécifiques, de ce que les machines peuvent faire en théorie. Par exemple, le programme [ELIZA](/wiki/ELIZA "ELIZA") pouvait se faire passer pour un psychothérapeute, et le [Logic Theorist](/wiki/Logic_Theorist "Logic Theorist") pouvait démontrer des théorèmes[[44]](#cite_note-:03-45).

La fin du siècle a été marquée par des périodes d'enthousiasme, et deux périodes de désillusion et de gel des financements appelées « hivers de l'IA »[[45]](#cite_note-46), la première de 1974 à 1980 et la seconde de 1987 à 1993. Les [systèmes experts](/wiki/Syst%C3%A8me_expert "Système expert") ont été particulièrement populaires dans les années 1980, malgré leur fragilité et la difficulté à implémenter manuellement les bonnes règles d'[inférences](/wiki/Inf%C3%A9rence_(logique) "Inférence (logique)")[[44]](#cite_note-:03-45). Des techniques d | fr | ai.md |

'[apprentissage automatique](/wiki/Apprentissage_automatique "Apprentissage automatique") se sont développées ([réseaux de neurones](/wiki/R%C3%A9seau_de_neurones_artificiels "Réseau de neurones artificiels"), [rétropropagation du gradient](/wiki/R%C3%A9tropropagation_du_gradient "Rétropropagation du gradient"), [algorithmes génétiques](/wiki/Algorithme_g%C3%A9n%C3%A9tique "Algorithme génétique")) ainsi que l'approche [connexionniste](/wiki/Connexionnisme "Connexionnisme")[[44]](#cite_note-:03-45). Mais les faibles puissances de calcul et le manque de données d'entraînement limitait leur efficacité. Certains domaines n'ont progressivement plus été considérés comme faisant partie de l'intelligence artificielle, à mesure qu'une solution efficace était trouvée[[46]](#cite_note-47) ; un phénomène parfois appelé « [effet IA](/wiki/Effet_IA "Effet IA") ».

Dans les années 2000, le [Web 2.0](/wiki/Web_2.0 "Web 2.0"), le *[big data](/wiki/Big_data "Big data")* et de nouvelles infrastructures et capacités de calcul ont permis l'exploration de masses de données sans précédent. En 2005, le projet *[Blue Brain](/wiki/Blue_Brain "Blue Brain")* a débuté, ayant pour objectif de [simuler le cervea | fr | ai.md |

u](/wiki/Cerveau_artificiel "Cerveau artificiel") de [mammifères](/wiki/Mammif%C3%A8re "Mammifère")[[47]](#cite_note-48). En 2012, avec le [réseau neuronal convolutif](/wiki/R%C3%A9seau_neuronal_convolutif "Réseau neuronal convolutif") Alexnet, a débuté l'utilisation de [processeurs graphiques](/wiki/Processeur_graphique "Processeur graphique") pour entraîner des [réseaux de neurones](/wiki/R%C3%A9seau_de_neurones_artificiels "Réseau de neurones artificiels"), décuplant ainsi les capacités de calcul dédiées à l'apprentissage[[48]](#cite_note-49). Des organisations visant à créer une [intelligence artificielle générale](/wiki/Intelligence_artificielle_g%C3%A9n%C3%A9rale "Intelligence artificielle générale") ont vu le jour, comme [DeepMind](/wiki/DeepMind "DeepMind") en 2010[[49]](#cite_note-50) et [OpenAI](/wiki/OpenAI "OpenAI") en 2015[[50]](#cite_note-51).

En 2017, des chercheurs de [Google](/wiki/Google "Google") ont proposé l'architecture [transformeur](/wiki/Transformeur "Transformeur"), qui a servi de base aux grands modèles de langage. En 2018, [Yann Le Cun](/wiki/Yann_Le_Cun "Yann Le Cun"), [Yoshua Bengio](/wiki/Yoshua_Bengio "Yoshua Bengio") et [Geoffrey Hinton](/wiki/Geof | fr | ai.md |

frey_Hinton "Geoffrey Hinton") ont remporté le [prix Turing](/wiki/Prix_Turing "Prix Turing") pour leurs travaux sur l'[apprentissage profond](/wiki/Apprentissage_profond "Apprentissage profond")[[51]](#cite_note-52),[[52]](#cite_note-53).

En 2022, des programmes générant des images à partir de descriptions textuelles, comme [Midjourney](/wiki/Midjourney "Midjourney") ou [DALL-E 2](/wiki/DALL-E "DALL-E"), se sont popularisés[[53]](#cite_note-54), et l'agent conversationnel [ChatGPT](/wiki/ChatGPT "ChatGPT") a affiché une croissance inédite, gagnant un million d'utilisateurs en seulement cinq jours[[54]](#cite_note-55) et cent millions d'utilisateurs en deux mois[[55]](#cite_note-56), ce qui a accentué un phénomène de « course » à l'IA[[56]](#cite_note-57). En 2023, les progrès rapides de l'IA ont suscité des inquiétudes quant à un potentiel risque d'[extinction de l'humanité](/wiki/Extinction_de_l%27humanit%C3%A9 "Extinction de l'humanité")[[57]](#cite_note-58). Des modèles traitant simultanément plusieurs modalités (texte, images, son), ont émergé (dont [Google Gemini](/wiki/Google_Gemini "Google Gemini"))[[58]](#cite_note-59).

Intelligence artificielle générale[[modifier](/w/in | fr | ai.md |

dex.php?title=Intelligence_artificielle&veaction=edit§ion=14 "Modifier la section: Intelligence artificielle générale") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=14 "Modifier le code source de la section : Intelligence artificielle générale")]

-------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

L'intelligence artificielle générale (IAG) comprend tout système informatique capable d'effectuer ou d'apprendre pratiquement n'importe quelle tâche [cognitive](/wiki/Cognition "Cognition") propre aux humains ou autres animaux[[59]](#cite_note-Intelligence_artificielle_g%C3%A9n%C3%A9rale_%E2%80%94_DataFranca-60). Elle peut alternativement être définie comme un système informatique surpassant les humains dans la plupart des tâches ayant un intérêt économique[[60]](#cite_note-61).

L'intelligence artificielle générale a longtemps été considérée comme un sujet | fr | ai.md |

purement spéculatif[[61]](#cite_note-:32-62). Certains travaux de recherche ont déjà décrit [GPT-4](/wiki/GPT-4 "GPT-4") comme ayant des « étincelles » d'[intelligence artificielle générale](/wiki/Intelligence_artificielle_g%C3%A9n%C3%A9rale "Intelligence artificielle générale")[[62]](#cite_note-63),[[63]](#cite_note-64). Les experts en intelligence artificielle affichent de larges désaccords et incertitudes quant à la date potentielle de conception des premières intelligences artificielles générales (parfois appelées « intelligences artificielles de niveau humain »), leur impact sur la société, et leur potentiel à déclencher une « [explosion d'intelligence](/wiki/Explosion_d%27intelligence "Explosion d'intelligence") »[[64]](#cite_note-65).

Un sondage de 2022 suggère que 90 % des experts en IA pensent que l'IAG a plus d'une chance sur deux d'être réalisée dans les 100 ans, avec une date [médiane](/wiki/M%C3%A9diane_(statistiques) "Médiane (statistiques)") de 2061[[65]](#cite_note-66).

Une [superintelligence](/wiki/Superintelligence "Superintelligence") artificielle est un type hypothétique d'intelligence artificielle générale dont les capacités intellectuelles dépasseraient de | fr | ai.md |

loin celles des humains les plus brillants[[66]](#cite_note-67). Le philosophe [Nick Bostrom](/wiki/Nick_Bostrom "Nick Bostrom") note que les machines disposent de certains avantages par rapport aux cerveaux humain, notamment en ce qui concerne la mémoire, la vitesse (la fréquence des [processeurs](/wiki/Processeur "Processeur") étant de l'ordre de dix millions de fois plus élevée que celle des neurones biologiques) et la capacité à partager des connaissances[[67]](#cite_note-68).

#### Test de Turing[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=16 "Modifier la section: Test de Turing") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=16 "Modifier le code source de la section : Test de Turing")]

Dans le [test de Turing](/wiki/Test_de_Turing "Test de Turing"), une machine et un humain répondent textuellement aux questions d'un interrogateur humain. L'interrogateur ne les voit pas mais doit déterminer à partir des réponses textuelles lequel des deux est la machine. Pour passer le test, la machine doit parvenir une bonne partie du temps à tromper l'interrogateur. Ce test a été conçu par [Alan Turing](/wiki/Alan_Tur | fr | ai.md |

ing "Alan Turing") en 1950 dans l'article « *[Computing Machinery and Intelligence](/wiki/Computing_Machinery_and_Intelligence "Computing Machinery and Intelligence")* ». Initialement appelé le « jeu de l'imitation », son but était de fournir une expérience concrète pour déterminer si les machines peuvent penser[[68]](#cite_note-69).

#### Test du café[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=17 "Modifier la section: Test du café") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=17 "Modifier le code source de la section : Test du café")]

Imaginé par [Steve Wozniak](/wiki/Steve_Wozniak "Steve Wozniak"), le test du café consiste à placer un système intelligent dans un habitat américain moyen et à lui demander de faire un café[[69]](#cite_note-70). La réussite du test implique donc plusieurs tâches comme l'orientation dans un environnement inconnu, déduire le fonctionnement d'une machine, trouver les ustensiles nécessaires..

Proposé par [Ben Goertzel](/wiki/Ben_Goertzel "Ben Goertzel"), le test de l'étudiant évalue la capacité d'un robot à s'inscrire dans un établissement d'enseignement supérieur, suivre les | fr | ai.md |

cours, passer les examens et obtenir le diplôme final[[70]](#cite_note-71).

Proposé par le chercheur [Nils John Nilsson](/wiki/Nils_John_Nilsson "Nils John Nilsson"), le test de l'embauche consiste à faire postuler un système intelligent à un travail important[[C'est-à-dire ?]](/wiki/Aide:Pr%C3%A9ciser_un_fait "Aide:Préciser un fait"), où il doit travailler au moins aussi bien qu'un humain[[71]](#cite_note-72).

Plusieurs [prix Turing](/wiki/Prix_Turing "Prix Turing") (ACM Turing Award) ont été attribués à des pionniers de l'intelligence artificielle, notamment :

En 2023, le magazine *[Time](/wiki/Time_(magazine) "Time (magazine)")* publie une liste de 100 personnalités influentes du domaine de l'IA et leurs biographies[[74]](#cite_note-75).

On peut considérer différents dispositifs intervenant, ensemble ou séparément, dans un système d'intelligence artificielle tels que :

Les réalisations actuelles de l'intelligence artificielle peuvent intervenir notamment dans les fonctions suivantes :

* l'aide aux [diagnostics](/wiki/Diagnostic_(m%C3%A9decine) "Diagnostic (médecine)") ;

* l'[aide à la décision](/wiki/Aide_%C3%A0_la_d%C3%A9cision "Aide à la décision") ;

* la résolution de p | fr | ai.md |

roblèmes complexes, tels que les [problèmes d'allocation de ressources](/wiki/Probl%C3%A8me_d%27affectation "Problème d'affectation") ;

* l'assistance par des machines dans les tâches dangereuses, ou demandant une grande précision ;

* l'automatisation de tâches.

L'intelligence artificielle a été utilisée (ou intervient) dans une variété de domaines.

### Finance et banques[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=25 "Modifier la section: Finance et banques") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=25 "Modifier le code source de la section : Finance et banques")]

Plusieurs grands noms de la finance se sont montrées intéressées par de telles technologies, avec des projets comme ceux de [Bridgewater Associates](/wiki/Bridgewater_Associates "Bridgewater Associates") où une intelligence artificielle va gérer entièrement un fonds[[77]](#cite_note-78) ou encore la plateforme d'analyse prédictive [Sidetrade](/wiki/Sidetrade "Sidetrade").

Sont également développés des systèmes de [trading algorithmique](/wiki/Trading_algorithmique "Trading algorithmique"), dont les gains de vitesses permis par l'automatisa | fr | ai.md |

tion peuvent leur donner un avantage par rapport à des [traders](/wiki/Op%C3%A9rateur_de_march%C3%A9 "Opérateur de marché") humains, en particulier grâce au [trading à haute fréquence](/wiki/Transactions_%C3%A0_haute_fr%C3%A9quence "Transactions à haute fréquence")[[78]](#cite_note-79).

Le domaine [militaire](/wiki/Militaire "Militaire") utilise de plus en plus l'intelligence artificielle, notamment pour le [pilotage automatique](/wiki/Pilote_automatique "Pilote automatique"), le [guidage de missiles](/wiki/Guidage_de_missile "Guidage de missile"), l'identification, le commandement, l'[aide à la décision](/wiki/Aide_%C3%A0_la_d%C3%A9cision "Aide à la décision")[[79]](#cite_note-80), la [cyberguerre](/wiki/Cyberguerre "Cyberguerre") et la [cyberdéfense](/wiki/Cyberd%C3%A9fense "Cyberdéfense")[[80]](#cite_note-81), ou pour la documentation et les processus administratifs[[81]](#cite_note-:04-82).

Cette [course aux armements](/wiki/Course_aux_armements "Course aux armements") est notamment illustrée par le projet *Maven* aux États-Unis[[82]](#cite_note-83). Dès 2015, une IA nommée *ALPHA* a « systématiquement triomphé d'un pilote de chasse chevronné »[[83]](#cite_note-84). En 2018, | fr | ai.md |

l'ONU a tenté d'interdire les [systèmes d'armes létales autonomes](/wiki/Syst%C3%A8me_d%27armes_l%C3%A9tales_autonome "Système d'armes létales autonome") « avant qu'il ne soit trop tard », mais peine encore en janvier 2024 à établir le moindre cadre légal international face aux réticences, notamment de la Russie, des États-Unis et d'Israël, dont le [veto](/wiki/Veto "Veto") peut bloquer une proposition[[84]](#cite_note-85). Des [drones tueurs](/wiki/Drone_de_combat "Drone de combat") pilotés par intelligence artificielle ont été utilisés lors du [conflit ukraino-russe](/wiki/Guerre_russo-ukrainienne "Guerre russo-ukrainienne")[[85]](#cite_note-86). Le 10 janvier 2024, [OpenAI](/wiki/OpenAI "OpenAI") a modifié ses conditions d'utilisation ; il continue d'interdire l'usage de ses services tels que ChatGPT à des fins illégales ou de destruction des biens, mais n'interdit plus explicitement les usages militaires[[86]](#cite_note-87). L'[intelligence artificielle générative](/wiki/Intelligence_artificielle_g%C3%A9n%C3%A9rative "Intelligence artificielle générative") est parfois utilisée par les institutions militaires pour rédiger plus vite la documentation, mais son adoption est limité | fr | ai.md |

e par la confidentialité des données, les réglementations, ou le risque d'erreur et le besoin de vérification[[81]](#cite_note-:04-82).

En France, la [force opérationnelle](/wiki/Force_op%C3%A9rationnelle "Force opérationnelle") IA du [ministère des Armées](/wiki/Minist%C3%A8re_des_Arm%C3%A9es "Ministère des Armées") rend en septembre 2019 un rapport détaillant sa stratégie, qui inclut la création d'une Cellule de coordination de l'intelligence artificielle de défense (CCIAD) rattachée à l'[Agence de l'innovation de défense](/wiki/Direction_g%C3%A9n%C3%A9rale_de_l%27Armement#L'agence_de_l'innovation_de_d%C3%A9fense "Direction générale de l'Armement")[[87]](#cite_note-88). La [loi de programmation militaire](/wiki/Loi_de_programmation_militaire_2019-2025 "Loi de programmation militaire 2019-2025") prévoit un budget de 700 millions d'euros pour les missions en faveur de l'IA, soit une moyenne de 100 millions par an[[88]](#cite_note-89). La France est opposée aux armes pouvant attaquer des cibles de façon complètement autonome, estimant qu'il est au moins nécessaire de conserver une supervision humaine[[89]](#cite_note-90),[[90]](#cite_note-91).

L'état [israélien](/wiki/Isra%C3%A9li | fr | ai.md |

ens "Israéliens") a été soupçonné d'utiliser l'intelligence artificielle pour dans le cadre de la [guerre Israël-Hamas de 2023-2024](/wiki/Guerre_Isra%C3%ABl-Hamas_de_2023-2024 "Guerre Israël-Hamas de 2023-2024"). Israël a utilisé deux systèmes d'IA pour générer des cibles à frapper : Habsora (traduit : « l'évangile ») a été utilisé pour dresser une liste de bâtiments à cibler, tandis que « Lavande » a produit une liste de personnes. « Lavande » a produit une liste de 37 000 personnes à cibler[[91]](#cite_note-92),[[92]](#cite_note-davies-93). La liste des bâtiments à cibler comprenait les maisons privées de Gaza de personnes soupçonnées d'être affiliées à des membres du Hamas. La combinaison de la technologie de ciblage de l'IA et du changement de politique consistant à éviter les cibles civiles a entraîné un nombre sans précédent de morts civiles. Les responsables de Tsahal affirment que le programme répond au problème précédent du manque d'objectifs de l'armée de l'air[[92]](#cite_note-davies-93).

La [médecine](/wiki/M%C3%A9decine "Médecine") a aussi vu de grands progrès grâce à l'utilisation de systèmes d'aide au [diagnostic](/wiki/Diagnostic_(m%C3%A9decine) "Diagnostic (médec | fr | ai.md |

ine)") ou de diagnostic automatisé[[93]](#cite_note-94).

En 2018, [Google DeepMind](/wiki/Google_DeepMind "Google DeepMind"), filiale de [Google](/wiki/Google "Google") spécialisée dans la recherche avancée en intelligence artificielle, a publié les résultats d'une expérimentation d'intelligence artificielle pouvant détecter les maladies oculaires. Les résultats indiquent que l'IA le fait avec une marge d'erreur plus faible que les ophtalmologues[[94]](#cite_note-95).

Google DeepMind a également conçu [AlphaFold](/wiki/AlphaFold "AlphaFold"), un système d'intelligence artificielle utilisant l'apprentissage profond qui permet de prédire la façon dont des [protéines](/wiki/Prot%C3%A9ine "Protéine") se replient. Les protéines sont composées de chaînes d'[acides aminés](/wiki/Acide_amin%C3%A9 "Acide aminé") et la façon dont elles se replient détermine leur fonction. Cette nouvelle méthode, introduite en 2018 et améliorée en 2020, est nettement plus rapide que les approches traditionnelles et a été décrite comme une révolution dans le domaine de la recherche en biologie[[95]](#cite_note-96),[[96]](#cite_note-97).

La France crée en 2019 le [Health Data Hub](/wiki/Health_Data_Hub "Heal | fr | ai.md |

th Data Hub") afin d'encadrer et de faciliter l'utilisation des données de santé dans la recherche[[97]](#cite_note-98).

En 2023, la version de ChatGPT reposant sur [GPT-4](/wiki/GPT-4 "GPT-4") s'est montrée facilement capable d'obtenir le diplôme de médecin aux États-Unis[[98]](#cite_note-99).

Un usage de l'IA se développe dans le domaine de la prévention des [crimes](/wiki/Crime "Crime") et [délits](/wiki/D%C3%A9lit_p%C3%A9nal "Délit pénal"). La [police britannique](/wiki/Police_au_Royaume-Uni "Police au Royaume-Uni"), par exemple, développe une IA de ce genre, annoncée comme pouvant être opérationnelle dès mars 2019[[99]](#cite_note-100). Baptisée National Data Analytics Solution (Solution nationale d'analyse de données ou NDAS), elle repose sur l'IA et des statistiques et vise à estimer le risque qu'une personne commette un crime ou en soit elle-même victime, pour orienter les services sociaux et médicaux qui peuvent la conseiller.

L'usage d'outils de prédiction des crimes à partir des données préalablement existantes est toutefois l'objet de controverses, compte tenu des biais sociaux (notamment raciaux) qu'il comporte[[100]](#cite_note-101). En effet, la logique d'identifi | fr | ai.md |

cation de schémas propre à ces technologies joue un rôle de renforcement des préjugés déjà existants.

L'intelligence artificielle (IA) est de plus en plus exploitée dans le domaine du cybercrime, comme le révèle une étude de la société spécialisée en cybersécurité [SlashNext](/w/index.php?title=SlashNext&action=edit&redlink=1 "SlashNext (page inexistante)"). Cette tendance croissante à l'utilisation de l'IA pour commettre des crimes en ligne montre une sophistication accrue des attaques. L'entreprise SlashNext a notamment identifié l'usage de deux IA malicieuses, [FraudGPT](/w/index.php?title=FraudGPT&action=edit&redlink=1 "FraudGPT (page inexistante)") et [WormGPT](/w/index.php?title=WormGPT&action=edit&redlink=1 "WormGPT (page inexistante)"), tout en suggérant que ces découvertes ne représentent que la partie visible d'une menace potentiellement colossale. Lors de leurs investigations, les chercheurs ont également mis en lumière l'existence de DarkBart et DarkBert[[b]](#cite_note-102), deux chatbots malveillants en développement, capables d'intégrer la technologie de reconnaissance d'images de Google [Google Lens](/wiki/Google_Lens "Google Lens"). Ces chatbots pourraient envoyer | fr | ai.md |

du texte et des images, et participer à des attaques d'[ingénierie sociale](/wiki/Ing%C3%A9nierie_sociale_(s%C3%A9curit%C3%A9_de_l%27information) "Ingénierie sociale (sécurité de l'information)") avancées. Face à cette menace croissante, les solutions actuelles de lutte contre le cybercrime semblent insuffisantes, estime un rapport d'Immunefi, qui souligne les limites de certaines IA, telles que ChatGPT, dans la détection des exploits[[101]](#cite_note-103).

Le [droit](/wiki/Droit "Droit") fait appel à l'IA dans la perspective de prédire les décisions de justice, d'aider à la décision et de trancher les cas simples[[102]](#cite_note-104). L'[Estonie](/wiki/Estonie "Estonie") a par exemple développé une intelligence artificielle capable de prendre des décisions de justice sur des délits mineurs[[103]](#cite_note-:1-105). Les États-Unis utilisent par ailleurs dans certaines juridictions le système [COMPAS](/w/index.php?title=COMPAS&action=edit&redlink=1 "COMPAS (page inexistante)") [(en)](https://en.wikipedia.org/wiki/COMPAS "en:COMPAS")(*Correctional Offender Management profiling for Alternative Sanctions*), un système d'aide à la prise de décision pour les juges[[103]](#cite_note | fr | ai.md |

-:1-105). Plusieurs *startups* se sont spécialisées dans ce créneau, créant le domaine de la *[legaltech](/wiki/Legaltech "Legaltech")*[[104]](#cite_note-106).

### Logistique et transports[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=31 "Modifier la section: Logistique et transports") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=31 "Modifier le code source de la section : Logistique et transports")]

Le domaine de la [logistique](/wiki/Logistique "Logistique") a vu certains projets utilisant de l'intelligence artificielle se développer notamment pour la gestion de la [chaîne logistique](/wiki/Gestion_de_la_cha%C3%AEne_logistique "Gestion de la chaîne logistique") (*supply chain*) ou des problématiques de livraison telle celle du [dernier kilomètre](/wiki/Dernier_kilom%C3%A8tre "Dernier kilomètre")[[105]](#cite_note-107).

L'intelligence artificielle est également fortement utilisée dans le domaine des [transports en commun](/wiki/Transports_en_commun "Transports en commun"), car elle permet de faciliter la régulation et la gestion du trafic au sein de réseaux de plus en plus complexes, comme le système [Urba | fr | ai.md |

nLoop](/wiki/UrbanLoop "UrbanLoop") actuellement en cours d'étude dans la ville de [Nancy](/wiki/Nancy "Nancy")[[106]](#cite_note-108).

Même si les problèmes d'optimisation de temps de trajet ou de transports font partie des plus anciennes applications de solutions à base d'intelligence artificielle (voir le [problème du voyageur de commerce](/wiki/Probl%C3%A8me_du_voyageur_de_commerce "Problème du voyageur de commerce") ou l'[algorithme de Dijkstra](/wiki/Algorithme_de_Dijkstra "Algorithme de Dijkstra")), les avancées récentes, notamment en [apprentissage profond](/wiki/Apprentissage_profond "Apprentissage profond"), ont permis des progrès significatifs en matière de précision. Certains projets comme [Google Maps](/wiki/Google_Maps "Google Maps") utilisent par exemple des systèmes d'IA en milieu urbain pour compenser la réflexion du signal [GPS](/wiki/Global_Positioning_System "Global Positioning System") sur les immeubles avoisinant[[107]](#cite_note-109), ou pour cartographier des zones où peu d'informations sont disponibles[[108]](#cite_note-110),[[109]](#cite_note-111).

Plusieurs entreprises ont par ailleurs annoncé avoir développé des programmes de recherche en [voiture aut | fr | ai.md |

onome](/wiki/V%C3%A9hicule_autonome "Véhicule autonome"), notamment [Google](/wiki/Google "Google") à travers sa filiale [Waymo](/wiki/Voiture_sans_conducteur_de_Google "Voiture sans conducteur de Google"), l'entreprise française [Navya](/wiki/Navya "Navya") ou encore [Tesla](/wiki/Tesla_(automobile) "Tesla (automobile)").

Les systèmes intelligents deviennent monnaie courante dans de nombreuses industries. Plusieurs tâches peuvent leur être confiées, notamment celles considérées comme trop dangereuses pour un humain[[110]](#cite_note-:5-112). Certains applications se concentrent sur les systèmes de [maintenance prédictive](/wiki/Maintenance_pr%C3%A9visionnelle "Maintenance prévisionnelle"), permettant des gains de performance grâce à une détection des problèmes de production en amont.

[](/wiki/Fichier:NAO_waving.JPG)Un [robot](/wiki/Robot "Robot") [NAO](/wiki/NAO_(robotique) "NAO (robotique)") en 2014.

Article connexe : [Robotique](/wiki/Robotique "Robotique")

La [robotique](/wiki/Robotique "Robotique") a recours à l'intelligence artificielle à plusieurs égards. Notamment pour la percept | fr | ai.md |

ion de l'environnement ([objets](/wiki/Reconnaissance_de_formes "Reconnaissance de formes") et [visages](/wiki/Syst%C3%A8me_de_reconnaissance_faciale "Système de reconnaissance faciale")), l'[apprentissage](/wiki/Apprentissage_automatique "Apprentissage automatique") et l'intelligence artificielle développementale[[111]](#cite_note-JITEC2018-113),[[112]](#cite_note-114).

L'[interaction homme-robot](/wiki/Interaction_homme-robot "Interaction homme-robot") manque encore souvent de naturel et est un enjeu de la robotique. Il s'agit de permettre aux robots d'évoluer dans le monde dynamique et social des humains et d'échanger avec eux de façon satisfaisante[[111]](#cite_note-JITEC2018-113). L'échange nécessite également, à l'inverse, une évolution du regard que les humains portent sur les robots ; selon Véronique Aubergé, chercheuse à l'[Université Grenoble-Alpes](/wiki/Universit%C3%A9_Grenoble-Alpes "Université Grenoble-Alpes") « la vraie révolution n'est pas technologique, elle est culturelle ». D'ores et déjà, à travers les robots dotés d'intelligence artificielle, tel [Google Home](/wiki/Google_Home "Google Home"), les utilisateurs combleraient un [isolement social](/wiki/Isolement | fr | ai.md |

_social "Isolement social")[[111]](#cite_note-JITEC2018-113).

L'intelligence artificielle est par exemple utilisée pour animer les [personnages non-joueurs](/wiki/Personnage_non-joueur "Personnage non-joueur") de jeux vidéo, qui sont conçus pour servir d'opposants, d'aides ou d'accompagnants lorsque des joueurs humains ne sont pas disponibles ou désirés. Différents niveaux de complexité sont développés, d'une simple assistance à un comportement complexe imitant (ou dépassant) les meilleurs joueurs humains.

Dès la fin des années 1980, des artistes s'emparent de l'intelligence artificielle pour donner un comportement autonome à leurs uvres. Les Français [Michel Bret](/wiki/Michel_Bret "Michel Bret"), [Edmond Couchot](/wiki/Edmond_Couchot "Edmond Couchot") et Marie-Hélène Tramus sont des pionniers, ainsi qu'en témoignent des uvres comme *La Plume* et *Le Pissenlit* (1988)[[113]](#cite_note-115), puis *La Funambule* (2000), animée par un [réseau de neurones](/wiki/R%C3%A9seau_de_neurones_artificiels "Réseau de neurones artificiels"). L'Américain [Karl Sims](/wiki/Karl_Sims "Karl Sims"), en partenariat avec la société [Thinking Machines](/wiki/Thinking_Machines_Corporation "Thinking M | fr | ai.md |

achines Corporation"), crée en 1993 *Genetic Images*, machines incorporant[[Comment ?]](/wiki/Aide:Pr%C3%A9ciser_un_fait "Aide:Préciser un fait") des [algorithmes génétiques](/wiki/Algorithme_g%C3%A9n%C3%A9tique "Algorithme génétique"). Le couple franco-autrichien [Christa Sommerer et Laurent Mignonneau](/wiki/Christa_Sommerer_et_Laurent_Mignonneau "Christa Sommerer et Laurent Mignonneau") crée depuis le début des années 1990 de nombreuses uvres dans le champ de la vie artificielle, parmi lesquelles *Interactive plant growing* (1992) ou *A-Volve* (1994)[[réf. nécessaire]](/wiki/Aide:R%C3%A9f%C3%A9rence_n%C3%A9cessaire "Aide:Référence nécessaire"). Le Français [Florent Aziosmanoff](/wiki/Florent_Aziosmanoff "Florent Aziosmanoff") propose quant à lui de considérer que l'emploi de l'intelligence artificielle dans l'art conduit à l'émergence d'une nouvelle discipline d'expression, qu'il nomme le Living art[[114]](#cite_note-116).

Le 23 octobre 2018, la société de vente aux enchères [Christie's](/wiki/Christie%27s "Christie's") met en vente le tableau *[Portrait d'Edmond de Belamy](/wiki/Portrait_d%27Edmond_de_Belamy "Portrait d'Edmond de Belamy")* réalisé par une intelligence artifici | fr | ai.md |

elle à l'aide de [réseaux antagonistes génératifs](/wiki/R%C3%A9seaux_antagonistes_g%C3%A9n%C3%A9ratifs "Réseaux antagonistes génératifs"). La peinture est signée par la [formule mathématique](/wiki/Formule_math%C3%A9matique "Formule mathématique") à l'origine de sa création (« Min (G) max (D) Ex [log (D(x))] + Ez [log(1-D(G(z)))] »)[[115]](#cite_note-117). Cette vente soulève de nombreux débats sur son statut de [création artistique](/wiki/Cr%C3%A9ation_artistique "Création artistique") et sur l'auteur de l'uvre : il peut être l'intelligence artificielle elle-même ou les trois créateurs qui l'ont programmée[[116]](#cite_note-118).

[](/wiki/Fichier:%22young_Elon_Musk_stops_playing_Mars_Marauder_and_starts_coding_web_software%22_(fictional_AI-generated_Joseph_Ayerle_artwork).jpg)Une fausse photo du jeune Elon Musk jouant au jeu vidéo Mars Marauder en 199 | fr | ai.md |

5, générée par l'IADes [réseaux antagonistes génératifs](/wiki/R%C3%A9seaux_antagonistes_g%C3%A9n%C3%A9ratifs "Réseaux antagonistes génératifs") ont parfois été utilisés pour créer de fausses images réalistes, comme avec le générateur de visages [StyleGAN](/wiki/StyleGAN "StyleGAN") introduit en 2018[[117]](#cite_note-119)*,* ou avec « Terre Seconde » de [Grégory Chatonsky](/wiki/Gr%C3%A9gory_Chatonsky "Grégory Chatonsky") qui imagine en 2019 une version alternative de la planète Terre[[118]](#cite_note-120).

Dès 2022 apparaissent des modèles d'intelligence artificielle qui sont capables de créer des images réalistes à partir de descriptions textuelles, comme [Midjourney](/wiki/Midjourney "Midjourney"), [Stable Diffussion](/wiki/Stable_Diffusion "Stable Diffusion") et [DALL-E](/wiki/DALL-E "DALL-E")[[119]](#cite_note-121),[[120]](#cite_note-122). En mars 2023, des fausses photos d'actualité sont ainsi générées et diffusées sur Internet, mettant en scène des personnalités dans des situations extravagantes (le président [Macron](/wiki/Emmanuel_Macron "Emmanuel Macron") ramassant des poubelles, [Donald Trump](/wiki/Donald_Trump "Donald Trump") arrêté par des policiers[[121]](#cite_no | fr | ai.md |

te-123), le [pape François](/wiki/Fran%C3%A7ois_(pape) "François (pape)") habillé en doudoune blanche[[122]](#cite_note-124)). Elles deviennent rapidement virales, augmentant les craintes de manipulation de l'opinion[[123]](#cite_note-125). Cela pose aussi des questions de droits d'auteur[[124]](#cite_note-126).

De plus en plus de romans ont été coécrits avec une IA générative, tels que *Internes* en 2022[[126]](#cite_note-128) ou (« La Tour de la compassion de Tokyo »), qui a reçu le [prix Akutagawa](/wiki/Prix_Akutagawa "Prix Akutagawa") en 2024[[127]](#cite_note-129).

En février 2024, le modèle [Sora](/wiki/Sora_(conversion_texte-vid%C3%A9o) "Sora (conversion texte-vidéo)") de OpenAI s'est montré capable de générer des vidéos relativement réalistes[[128]](#cite_note-130).

Des modèles d'IA capables de générer un [morceau de musique](/wiki/%C5%92uvre_musicale "uvre musicale") à partie d'une description du style souhaité ont également fait leur apparition, comme [Suno AI](/wiki/Suno_AI "Suno AI") en 2023 et [Udio](/wiki/Udio "Udio") en 2024[[129]](#cite_note-131).

La [domesticité](/wiki/Domesticit%C3%A9 "Domesticité"), avec des robots [employé de maison](/wiki/Employ%C3%A9_de_ | fr | ai.md |

maison "Employé de maison")[[130]](#cite_note-132), ou pour certaines tâches précises comme en [domotique](/wiki/Domotique "Domotique").

En programmation informatique, notamment pour la [maintenance prédictive](/wiki/Maintenance_pr%C3%A9dictive "Maintenance prédictive"), l'[autocomplétion](/wiki/Auto-compl%C3%A9tion "Auto-complétion") ou l'aide au développement[[131]](#cite_note-133).

En [journalisme](/wiki/Journalisme "Journalisme") : des IA (appelées improprement « robots journalistes ») pourraient à terme aider les journalistes en les débarrassant de certaines tâches, notamment la veille, le bâtonnage de dépêches ou la vérification des *[fake news](/wiki/Fake_news "Fake news")*[[132]](#cite_note-134).

La Corée du Sud propose la toute première animatrice télé virtuelle en novembre 2020 lors d'un JT[[133]](#cite_note-135).

En [design](/wiki/Design "Design") : la [conception assistée par ordinateur](/wiki/Conception_assist%C3%A9e_par_ordinateur "Conception assistée par ordinateur") fait depuis longtemps appel à des algorithmes d'optimisation. En 2019, le créateur [Philippe Starck](/wiki/Philippe_Starck "Philippe Starck") lance ainsi une chaise développée en collaboration avec l | fr | ai.md |

a société [Autodesk](/wiki/Autodesk "Autodesk"), la « A.I.chair »[[134]](#cite_note-136).

Les succès en IA encouragent les spéculations. Dans les [milieux technophiles](/wiki/Technophilie "Technophilie"), on verse en général dans l'enthousiasme, le [mouvement transhumaniste](/wiki/Transhumanisme "Transhumanisme") en est la meilleure expression. Mais certains s'inquiètent et s'interrogent, parfois alarmistes, y compris dans la sphère de la haute technologie. Ainsi, des figures réputées telles que [Bill Gates](/wiki/Bill_Gates "Bill Gates") - ancien PDG de [Microsoft](/wiki/Microsoft "Microsoft") et « figure emblématique de la révolution informatique de la fin du [XXe siècle](/wiki/XXe_si%C3%A8cle "XXe siècle") »[[135]](#cite_note-137) - pensent qu'il faut rester très prudent quant aux développements futurs de ces technologies, qui pourraient devenir liberticides ou dangereuses.

Le développement de l'intelligence artificielle suscite un grand nombre de questions, notamment en ce qui concerne la possibilité pour les IA ou algorithmes d'accéder un jour à la [conscience](/wiki/Conscience "Conscience"), d'éprouver des émotions ou de finalement se substituer aux humains. Certaines réact | fr | ai.md |

ions sont ouvertement optimistes, d'autres sont au contraire pessimistes. En 2016, l'[INRIA](/wiki/Institut_national_de_recherche_en_informatique_et_en_automatique "Institut national de recherche en informatique et en automatique") publie un premier [Livre blanc](/wiki/Livre_blanc "Livre blanc") consacré à l'IA[[136]](#cite_note-138).

Dans son essai *Intelligence artificielle, intelligence humaine : la double énigme*, le philosophe [Daniel Andler](/wiki/Daniel_Andler "Daniel Andler") considère que le rêve d'une intelligence artificielle qui rejoindrait celle de l'homme est une chimère, pour des causes conceptuelles et non techniques. L'intelligence humaine va selon lui plus loin que la simple résolution de problèmes : toutes ses autres tâches, reposant sur des affects, de la spontanéité et une forme de contingence, ne seront jamais accessibles à une intelligence non humaine[[137]](#cite_note-139).

Une description d'un possible avenir de l'intelligence artificielle a été faite par le statisticien anglais [Irving John Good](/wiki/Irving_John_Good "Irving John Good") :

[](/wiki/Fichier:Raymond_Kurzweil_Fantastic_Voyage.jpg)Pour l'Américain [Ray Kurzweil](/wiki/Raymond_Kurzweil "Raymond Kurzweil"), l'intelligence artificielle dépassera bientôt l'intelligence naturelle.

> « Supposons qu'existe une machine surpassant en intelligence tout ce dont est capable un homme, aussi brillant soit-il. La conception de telles machines faisant partie des activités intellectuelles, cette machine pourrait à son tour créer des machines meilleures qu'elle-même ; cela aurait sans nul doute pour effet une *réaction en chaîne* de développement de l'intelligence, pendant que l'intelligence humaine resterait presque sur place. Il en résulte que la machine ultra intelligente sera la dernière invention que l'homme aura besoin de faire, à condition que ladite machine soit assez docile pour constamment lui obéir. »

- [Irving John Good](/wiki/Irving_John_Good "Irving John Good")[[138]](#cite_note-140)

Cette hypothétique courte période de progrès drastique dont il est difficile de prédire les conséquences a été nommée « singularité ». Elle a été étudiée par [Vernor Vinge](/wiki/Vernor_Vinge "Vernor Vinge") dans les années 90 et par [Ray Kurzweill](/wi | fr | ai.md |

ki/Raymond_Kurzweil "Raymond Kurzweil")[[139]](#cite_note-141) dans les années 2000[[140]](#cite_note-:6-142). Ce concept est central pour de nombreux [transhumanistes](/wiki/Transhumanisme "Transhumanisme"), qui s'interrogent sur les dangers ou les espoirs d'un tel scénario, certains allant jusqu'à envisager l'émergence d'un « dieu » numérique appelé à prendre le contrôle du destin de l'[humanité](/wiki/Humanit%C3%A9 "Humanité"), ou à fusionner avec elle[[140]](#cite_note-:6-142). En 2014, [Nick Bostrom](/wiki/Nick_Bostrom "Nick Bostrom") a popularisé le concept de [superintelligence artificielle](/wiki/Superintelligence#Superintelligence_artificielle "Superintelligence")[[141]](#cite_note-143).

[](/wiki/Fichier:Vice_President_Harris_at_the_group_photo_of_the_2023_AI_Safety_Summit.jpg)Un premier sommet en [sûreté de l'IA](/wiki/S%C3%BBret%C3%A9_de_l%27IA "Sûreté de l'IA") s'est tenu en novembre 2023 pour aborder les risques liés aux modèles d'IA les plus avancés[[

142]](#c | fr | ai.md |

ite_note-144).

Le développement de l'intelligence artificielle génère de l'enthousiasme, mais aussi de vives inquiétudes. Certains auteurs de [science-fiction](/wiki/Science-fiction "Science-fiction"), tels [Isaac Asimov](/wiki/Isaac_Asimov "Isaac Asimov"), [William Gibson](/wiki/William_Gibson "William Gibson") ou [Arthur C. Clarke](/wiki/Arthur_C._Clarke "Arthur C. Clarke"), sur le modèle du récit de *[L'Apprenti sorcier](/wiki/L%27Apprenti_sorcier_(po%C3%A8me) "L'Apprenti sorcier (poème)")*, décrivent le risque d'une perte de contrôle des humains sur le processus technique. Dans les années 2010, différents intellectuels ont également pris position. Notamment l'[astrophysicien](/wiki/Astrophysique "Astrophysique") [Stephen Hawking](/wiki/Stephen_Hawking "Stephen Hawking"), selon qui l'intelligence artificielle risque réellement de surpasser un jour l'intelligence humaine et de finir par dominer l'humanité, voire de s'y substituer[[143]](#cite_note-145),[[144]](#cite_note-146). Il pose en novembre 2017 au salon technologique [Web Summit](/wiki/Web_Summit "Web Summit") de [Lisbonne](/wiki/Lisbonne "Lisbonne") la question suivante « Serons-nous aidés par l'intelligence artificielle | fr | ai.md |

ou mis de côté, ou encore détruits par elle ? »[[145]](#cite_note-147).

Dans le milieu de la haute technologie, certains expriment publiquement des craintes similaires. C'est ainsi le cas, en 2015, de [Bill Gates](/wiki/Bill_Gates "Bill Gates"), [Elon Musk](/wiki/Elon_Musk "Elon Musk") et [Bill Joy](/wiki/Bill_Joy "Bill Joy")[[146]](#cite_note-148). Selon le spécialiste américain de l'informatique [Moshe Vardi](/wiki/Moshe_Vardi "Moshe Vardi") en 2016, l'intelligence artificielle pourrait mettre 50 % de l'humanité au [chômage](/wiki/Ch%C3%B4mage "Chômage"). « Nous approchons d'une époque où les machines pourront surpasser les hommes dans presque toutes les tâches »[[147]](#cite_note-149).

[Hilary Mason](/wiki/Hilary_Mason_(entrepreneure) "Hilary Mason (entrepreneure)"), directrice de la recherche à [Cloudera](/wiki/Cloudera "Cloudera"), critique le sensationnalisme entourant l'intelligence artificielle et prône une vision utilitariste et technique de cette technologie[[148]](#cite_note-150).

Ajouter un mécanisme d'arrêt pourrait ne pas suffire face à une IA suffisamment avancée, qui pourrait s'avérer en mesure de cacher des intentions dangereuses, de manipuler ses détenteurs, de | fr | ai.md |

désactiver le mécanisme d'arrêt ou encore de se dupliquer. Selon Nick Bostrom, la seule solution viable à long terme consiste à trouver comment [aligner les intelligences artificielles](/wiki/Alignement_des_intelligences_artificielles "Alignement des intelligences artificielles") avec des valeurs humaines et morales[[149]](#cite_note-151) :

> « nous ne devrions pas être confiants dans notre capacité à garder indéfiniment un génie [superintelligent](/wiki/Superintelligence "Superintelligence") enfermé dans une bouteille. Je crois que la réponse ici est de trouver comment créer une IA superintelligente de sorte que si - ou plutôt quand - elle s'échappe, elle reste sans danger, parce qu'elle est fondamentalement de notre côté, elle partage nos valeurs. »

- [Nick Bostrom](/wiki/Nick_Bostrom "Nick Bostrom")

Roman V. Yampolskiy, professeur de science informatique à l'[Université de Louisville](/wiki/Universit%C3%A9_de_Louisville "Université de Louisville"), évoque pourquoi et comment une IA obtient un résultat, pour s'assurer qu'il corresponde bien à l'attendu, sans [biais](/wiki/Biais_cognitif "Biais cognitif") : « si nous nous habituons à accepter les réponses de l'IA comme des par | fr | ai.md |

oles d'oracles ne nécessitant pas d'explication, alors nous serons incapables de vérifier si ces résultats ne sont pas biaisés ou manipulés »[[150]](#cite_note-152).

En mai 2023, une déclaration du [Center for AI Safety](/wiki/Center_for_AI_Safety "Center for AI Safety") (« Centre pour la [sûreté de l'IA](/wiki/S%C3%BBret%C3%A9_de_l%27IA "Sûreté de l'IA") ») affirme que réduire le risque d'extinction de l'humanité lié à l'IA devrait être une priorité mondiale, au même titre que pour d'autres risques civilisationnels tels les [pandémies](/wiki/Pand%C3%A9mie "Pandémie") ou les [guerres nucléaires](/wiki/Guerre_nucl%C3%A9aire "Guerre nucléaire"). Elle est signée par des dirigeants de laboratoires d'IA comme [OpenAI](/wiki/OpenAI "OpenAI"), [Google DeepMind](/wiki/Google_DeepMind "Google DeepMind") ou [Anthropic](/wiki/Anthropic "Anthropic"), ainsi que par des chercheurs en intelligence artificielle[[151]](#cite_note-153),[[152]](#cite_note-154).

### Critique de la technique et de la technologie[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=40 "Modifier la section: Critique de la technique et de la technologie") | [modifier le code](/w/index.php?title= | fr | ai.md |

Intelligence_artificielle&action=edit§ion=40 "Modifier le code source de la section : Critique de la technique et de la technologie")]

Comme l'explique l'historien François Jarrige, la critique de l'intelligence artificielle trouve son origine dans celle - plus ancienne et plus générale - des techniques et de la technologie, dont [Lewis Mumford](/wiki/Lewis_Mumford "Lewis Mumford") (aux États-Unis)[[153]](#cite_note-155), [Jacques Ellul](/wiki/Jacques_Ellul "Jacques Ellul") (en France)[[154]](#cite_note-156) et [Günther Anders](/wiki/G%C3%BCnther_Anders "Günther Anders") (en Allemagne)[[155]](#cite_note-157) sont au XXe siècle les principaux instigateurs, et qui inspire aujourd'hui différents cercles militants (en France, par exemple : *Pièces et Main d'uvre*[[156]](#cite_note-158) et *Technologos*[[157]](#cite_note-159))[[158]](#cite_note-160).

Dans un rapport en date de février 2018 intitulé *The Malicious Use of Artificial Intelligence* 26 experts spécialistes en intelligence artificielle mettent en garde contre les dangers d'un usage criminel de l'IA : augmentation de la cybercriminalité, conduire à des utilisations de drones à des fins terroristes, manipulation de masse, | fr | ai.md |

etc.[[159]](#cite_note-161).

Un autre problème est l'énorme quantité de ressources rares, de serveurs et d'énergie consommée par l'informatique sous-jacente à l'IA.

Divers projets open source d'IA ont été menés par [Hugging Face](/wiki/Hugging_Face "Hugging Face")[[160]](#cite_note-162) et EleutherAI[[161]](#cite_note-:8-163), [Google](/wiki/Google "Google")[[162]](#cite_note-164), ou encore [Meta](/wiki/Meta_(entreprise) "Meta (entreprise)")[[161]](#cite_note-:8-163).

En mars 2023, comme alternative aux géants du Web et du *[cloud computing](/wiki/Cloud_computing "Cloud computing")*, qui ont le plus de pouvoir et d'influence, [Mozilla](/wiki/Mozilla_Foundation "Mozilla Foundation") a annoncé vouloir investir 30 millions de dollars dans un projet baptisé Mozilla.ai, qui est à la fois une [startup](/wiki/Startup "Startup") et une communauté, indépendante des géants de la tech et de la recherche académique[[163]](#cite_note-165). Le projet vise à créer, dans le respect des valeurs de son [manifeste](/wiki/Manifeste "Manifeste") (notamment transparence et responsabilité), un système d'IA « [open source](/wiki/Open_source "Open source"), digne de confiance et indépendant » qui puis | fr | ai.md |

se faire « contrepoids » aux IA privées en émergence[[164]](#cite_note-166).

De nombreux grands modèles de langage ont été rendus *open source*, ou plus exactement « *open weight* », ce qui signifie que l'architecture et les paramètres entraînés du modèle d'IA sont rendus publics[[165]](#cite_note-:9-167). Cela inclut notamment [Mistral](/wiki/Mistral_AI "Mistral AI")[[166]](#cite_note-168), [Llama 2](/wiki/LLaMA "LLaMA"), Vicuna et Falcon,[[167]](#cite_note-169). Ces modèles peuvent être librement [ajustés](/wiki/R%C3%A9glage_fin "Réglage fin"), ce qui permet notamment aux entreprises de les spécialiser pour leurs propres données et pour leur cas d'usage[[168]](#cite_note-170). Ces modèles d'IA facilitent l'innovation et la recherche, mais peuvent facilement être détournés. Ils peuvent être réentraînés de sorte à rendre inefficaces les mesures de sécurité, telles que le refus de répondre à une requête dangereuse. Certains chercheurs estiment ainsi que si des modèles développent un jour des capacités dangereuses, comme le fait de faciliter drastiquement les [cyberattaques](/wiki/Cyberattaque "Cyberattaque") ou le [bioterrorisme](/wiki/Bioterrorisme "Bioterrorisme"), ils ne devraie | fr | ai.md |

nt pas être rendus *open weight*, d'autant plus qu'une fois diffusé sur internet, un modèle ne peut en général plus être supprimé partout[[169]](#cite_note-171),[[165]](#cite_note-:9-167).

En 2017, les [Émirats arabes unis](/wiki/%C3%89mirats_arabes_unis "Émirats arabes unis") sont le premier pays au monde à se doter d'un ministre dédié à l'intelligence artificielle : [Omar Sultan Al Olama](/wiki/Omar_Sultan_Al_Olama "Omar Sultan Al Olama")[[170]](#cite_note-172).

En 2019, l'[OCDE](/wiki/OCDE "OCDE") et le [G20](/wiki/G20 "G20") adoptent une série de principes sur l'IA[[171]](#cite_note-173). Le [Partenariat mondial sur l'intelligence artificielle](/wiki/Partenariat_mondial_sur_l%27intelligence_artificielle "Partenariat mondial sur l'intelligence artificielle") est lancé en juin 2020 pour promouvoir la conformité du développement de l'IA aux droits de l'homme et aux valeurs démocratiques. Il est hébergé par l'[OCDE](/wiki/Organisation_de_coop%C3%A9ration_et_de_d%C3%A9veloppement_%C3%A9conomiques "Organisation de coopération et de développement économiques") à Montréal et à Paris[[172]](#cite_note-174). Une plateforme de communication, [AI for Good](/wiki/AI_for_Good "AI for Good" | fr | ai.md |

) (« l'IA pour le bien »), est créée pour faciliter les échanges et faire avancer les [objectifs de développement durable](/wiki/Objectifs_de_d%C3%A9veloppement_durable "Objectifs de développement durable") de l'[ONU](/wiki/ONU "ONU") grâce à l'IA[[173]](#cite_note-175).

En Europe, les services numériques sont réglementés par le [RGPD](/wiki/R%C3%A8glement_g%C3%A9n%C3%A9ral_sur_la_protection_des_donn%C3%A9es "Règlement général sur la protection des données")[[174]](#cite_note-176), la [législation sur les services numériques](/wiki/L%C3%A9gislation_sur_les_services_num%C3%A9riques "Législation sur les services numériques") et la [législation sur les marchés numériques](/wiki/L%C3%A9gislation_sur_les_march%C3%A9s_num%C3%A9riques "Législation sur les marchés numériques"). Pour l'intelligence artificielle en particulier, la [législation sur l'intelligence artificielle](/wiki/L%C3%A9gislation_sur_l%27intelligence_artificielle "Législation sur l'intelligence artificielle") (*Artificial Intelligence Act,* ou *AI Act* en anglais) définit quatre niveaux de risques pour les applications d'IA et met en avant des exigences de transparence, de protection des données, de sécurité et d'éthique[ | fr | ai.md |

[175]](#cite_note-177).

En 2023, plus de 1 600 politiques publiques et stratégies sur l'IA sont recensées dans le monde[[176]](#cite_note-IAHist2023-178). Elles viennent en particulier de l'Union européenne, la Chine, les États-Unis et le Royaume-Uni. Après les avancées réglementaires de l'UE et de la Chine, la Maison Blanche publie en octobre 2023 un décret sur l'IA « sûre, sécurisée et digne de confiance ». En novembre 2023 a lieu un premier sommet en [sécurité de l'IA](/wiki/S%C3%A9curit%C3%A9_de_l%27IA "Sécurité de l'IA") au Royaume-Uni[[176]](#cite_note-IAHist2023-178).

#### Droits des robots[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=44 "Modifier la section: Droits des robots") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=44 "Modifier le code source de la section : Droits des robots")]

En 2017, le [Parlement européen](/wiki/Parlement_europ%C3%A9en "Parlement européen") a demandé à une commission d'étudier la possibilité qu'un robot doté d'une intelligence artificielle puisse être considéré comme une personne juridique[[177]](#cite_note-179),[[178]](#cite_note-180). Advenant un dommage causé à un ti | fr | ai.md |

ers par une intelligence artificielle, celle-ci pourrait être condamnée à réparer ce dommage. Il serait envisageable de conférer une personnalité électronique à tout robot prenant des décisions autonomes ou interagissant de manière indépendante avec des tiers, au même titre qu'une personne morale et physique.

### Appels à des règles éthiques pour l'IA[[modifier](/w/index.php?title=Intelligence_artificielle&veaction=edit§ion=45 "Modifier la section: Appels à des règles éthiques pour l'IA") | [modifier le code](/w/index.php?title=Intelligence_artificielle&action=edit§ion=45 "Modifier le code source de la section : Appels à des règles éthiques pour l'IA")]

[](/wiki/Fichier:Circle-icons-scissors.svg)**[synthétisée](/wiki/Wikip%C3%A9dia:Style_encyclop%C3%A9dique "Wikipédia:Style encyclopédique")** (5 mars 2024).

Vous pouvez Cette section a besoin d'êtreVous pouvez [modifier cet article](https://fr.wikipedia.org/w/index.php?title=Intelligence_artificielle&action=edit) afin de le rendre plus concis et / ou plus précis.

Dans la seconde moitié des années 2010, des | fr | ai.md |

[lanceurs d'alerte](/wiki/Lanceur_d%27alerte "Lanceur d'alerte") et des enquêtes laissent penser que l'IA, encore émergente, est déjà utilisée à des fins malveillantes pour faire basculer des processus électoraux. Le premier cas détecté a été la [plate-forme RIPON](/wiki/Ripon_(plateforme_logicielle) "Ripon (plateforme logicielle)"), secrètement créée par le [Groupe SCL](/wiki/Groupe_SCL "Groupe SCL"), à la demande de [Steve Bannon](/wiki/Steve_Bannon "Steve Bannon") et du milliardaire américain [Robert Mercer](/wiki/Robert_Mercer_(homme_d%27affaires) "Robert Mercer (homme d'affaires)"), mise au service de groupes politiques presque tous libertariens de droite ; Ripon a été un outil de [désinformation](/wiki/D%C3%A9sinformation "Désinformation"), de production et de diffusion de *[fake news](/wiki/Fake_news "Fake news")* à grande échelle[[179]](#cite_note-RapportGvtRU_fev2019c-181)[[réf. non conforme]](/wiki/Aide:R%C3%A9f%C3%A9rence_non_conforme "Aide:Référence non conforme"),[[180]](#cite_note-182). Ripon ne sera découvert que parce qu'elle a été au cur du [scandale Facebook-Cambridge Analytica](/wiki/Scandale_Facebook-Cambridge_Analytica "Scandale Facebook-Cambridge Analytica")/ | fr | ai.md |